깊이 정보 추출을 위한 오프셋 화소 조리개가 적용된 단색 CMOS 이미지 센서의 디스패리티 추정

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(https://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

Abstract

In this paper, the estimation of the disparity for depth extraction in monochrome complementary metal–oxide–semiconductor (CMOS) image sensors with offset pixel apertures is presented. To obtain the depth information, the disparity information between two different channel data of the offset pixel apertures is required. The disparity is caused by the difference in the response angle between the left- and right-offset pixel aperture images. A depth map is implemented by the generated disparity. Therefore, the disparity is the most important factor for realizing 3D images from the designed CMOS image sensor with offset pixel apertures. The disparity is influenced by the pixel height and offset value of the offset pixel aperture. To confirm this correlation, the offset value is set to maximum within the pixel area, and the disparity values corresponding to the difference in the heights are calculated and compared. The disparity is derived using the camera-lens formula. Two monochrome CMOS image sensors with offset pixel apertures are used in the disparity estimation.

Keywords:

disparity, depth extraction, monochrome CMOS image sensor, offset pixel aperture1. 서 론

최근 CMOS 이미지 센서 연구의 동향은 고품질의 2차원 이미지 구현뿐만 아니라 3차원 이미지 구현에도 집중되고 있다. 3차원 이미지는 기존의 2차원 이미지에 깊이 정보가 포함되므로 전달할 수 있는 정보의 품질이 향상된다. 또한, 포함된 깊이 정보는 자동차, 의료 기기, 군사 용품 등과 같은 다양한 응용 분야에서 용이하게 활용된다 [1-4]. 물론, 3차원 이미지 구현을 위해서 Time-of-flight (TOF) 시스템, 스테레오 카메라 시스템, 구조 광 시스템과 같은 많은 방법들이 존재한다[5-8]. 그러나, 앞서 언급한 방법들에 비해 오프셋 화소 조리개 (offset pixel aperture: OPA) 방법은 하나의 칩 및 간단한 구조로 깊이 정보를 획득할 수 있다는 장점이 있다 [9-11].

본 논문에서는 오프셋 화소 조리개 방법이 적용된 센서에서 깊이 정보 추출에 가장 중요한 요소인 디스패리티 (disparity) 추정에 대해 논한다. 디스패리티는 오프셋 화소 조리개 패턴에서 왼쪽-오프셋 화소 조리개가 적용된 화소와 오른쪽-오프셋 화소 조리개가 적용된 화소 사이의 응답 각도 차이에 의해 생성된 다른 채널 두 이미지의 x축 방향 거리 차이이다.

응답 각도의 차이는 오프셋-화소 조리개의 오프셋 값과 픽셀 높이에 영향을 받는다. 본 논문에서, 디스패리티는 픽셀 높이가 다른 두 개의 단색 CMOS 이미지 센서를 이용하여 추정된다. 그 후, 픽셀 높이가 디스패리티에 얼마나 영향을 미치는지 확인한다.

2. 디스패리티

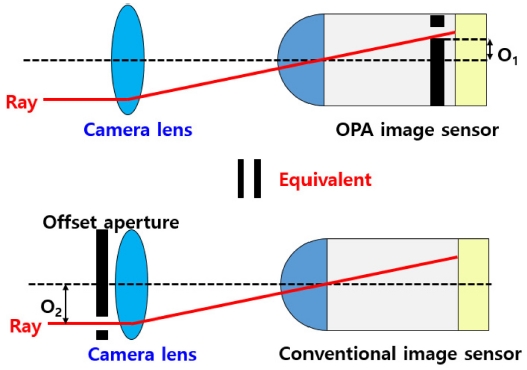

오프셋 화소 조리개 방법을 이용한 설계된 단색 CMOS 이미지 센서는 깊이 추출을 위한 중요한 요소인 디스패리티 추정에 이용된다. Fig. 1에서는 오프셋 화소 조리개와 카메라 렌즈 조리개의 효과가 동등함을 나타낸다. O1은 오프셋 화소 조리개의 오프셋 값이고, O2는 카메라 렌즈 조리개의 오프셋 값이다.

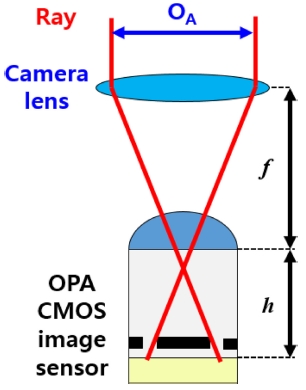

Fig. 2는 오프셋 화소 조리개 방법이 적용된 CMOS 이미지 센서의 단면도를 보여준다. 등가 오프셋 f-수 (FOA) 는 픽셀 높이에 반비례하며 다음의 식과 같다.

| (1) |

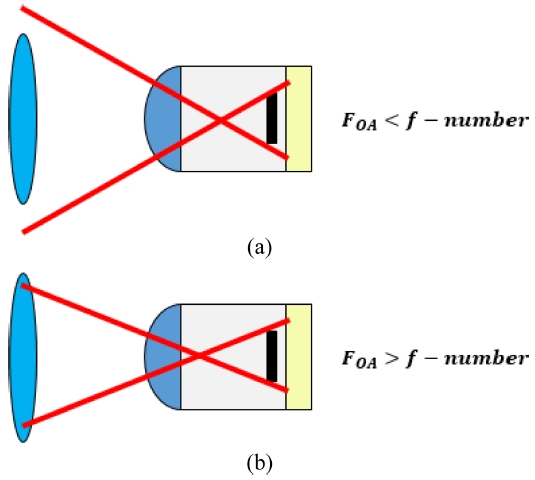

여기서 h는 픽셀 높이이고, 2 × O2는 OA와 동일하며, n은 마이크로 렌즈의 반사 지수이다. FOA가 카메라 렌즈의 f-수보다 작으면 디스패리티가 정확하게 최대로 얻어지지 않는다. 따라서, Fig. 3에서 보여지는 것처럼 FOA는 카메라 렌즈의 f-수보다 더 크게 설정되어야 하며, 왼쪽-오프셋 화소 조리개와 오른쪽-오프셋 화소 조리개의 대칭되는 개구영역에 의해 확인된다.

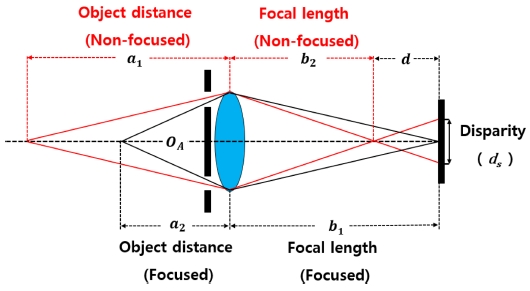

Fig. 4는 디스패리티에 대한 물체의 거리 및 초점 거리의 영향을 나타낸다. a1은 초점이 맞지 않은 상태에서의 물체 거리이고, a2는 초점이 맞는 상태에서의 물체거리이다. b1은 초점이 맞지 않은 상태에서의 초점 거리이고, b2는 초점이 맞을 때의 초점 거리이다. d는 초점이 맞지 않은 상태에서 센서와 초점 사이의 거리이다.

디스패리티(ds)의 정의는 다음 식과 같다.

| (2) |

| (3) |

| (4) |

디스패리티는 위에서 언급한 렌즈 수식을 이용하여 계산할 수 있다. 위 수식에서 보여지는 것처럼 픽셀 높이가 감소함에 따라 FOA가 감소하여 디스패리티는 증가한다.

3. 디스패리티의 추정

디스패리티는 이전 섹션에서 설명한 렌즈 수식에서 보여지는 것처럼 FOA의 크기에 따라 달라진다. 즉, 픽셀의 높이가 낮아지거나 오프셋 화소 조리개의 오프셋 값이 증가하면 디스패리티가 증가한다. 따라서, 오프셋 화소 조리개 방법으로 픽셀을 설계할 때, 픽셀 높이와 오프셋 값을 설정하는 것이 매우 중요하다. 디스패리티 추정에 이용한 오프셋 화소 조리개의 개구 영역 오프셋 값은 0.78 μm이다.

이는 화소 면적 2.8 μm × 2.8 μm 영역내에서 오프셋 화소 조리개의 개구 영역 폭을 0.5 μm로 형성할 때, 설정할 수 있는 최대 오프셋 값이다. 그런 다음, 고정된 오프셋 값에 대하여 픽셀 높이 변화가 디스패리티에 어떤 영향을 미치는지 확인하였다.

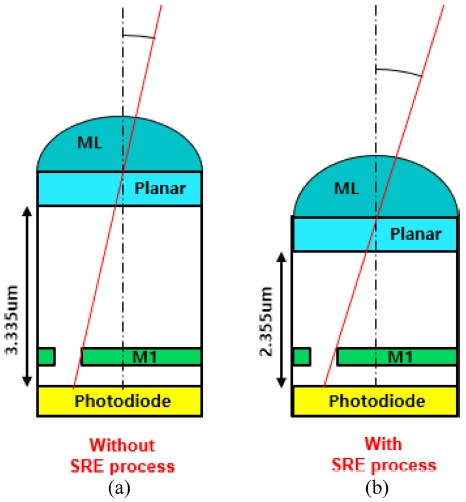

화소 높이 차이가 존재하는 두 센서를 이용하여 디스패리티를 추정하였다. Fig. 5는 실리콘 영역 에칭 공정 (SRE process) 적용 유무에 따른 픽셀 높이 차이에 대한 단면도를 나타낸다.

(a) and (b) Cross-sectional illustration of difference in pixel height depending on the presence or absence of the SRE process.

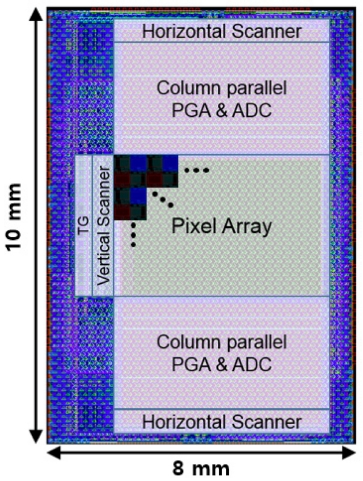

오프셋 화소 조리개 방법이 적용된 단색 CMOS 이미지 센서의 화소 높이를 감소시키기 위하여 실리콘 영역 에칭 공정을 적용하였다. 실리콘 영역 에칭 공정이 적용되지 않은 화소의 높이는 3.335 μm이며, 실리콘 영역 에칭 공정이 적용된 화소의 높이는 2.355 μm이다. 화소 높이의 차이는 0.98 μm이므로 실리콘 영역 에칭 공정이 적용된 화소의 높이가 낮은 것으로 확인되었다. 따라서, 고정된 오프셋 화소 조리개의 오프셋 값과 두 센서의 화소 높이를 이용하여 디스패리티 추정을 진행하였다. Fig. 6은 오프셋 화소 조리개 방법이 적용되어 설계된 단색 CMOS 이미지 센서의 레이아웃 사진이다. 설계된 단색 CMOS 이미지 센서의 특성은 Table 1에 서술하였다.

4. 결과 및 고찰

디스패리티는 설계된 오프셋 화소 조리개 CMOS 이미지 센서에서 깊이 정보를 획득하여 3차원 이미지를 구현함에 있어서 가장 중요한 요소이다. 디스패리티가 향상됨에 따라 깊이 정보의 해상도 또한 향상된다. 본 절에서는 화소의 높이가 디스패리티에 미치는 영향을 확인하기 위해 계산한 결과를 비교한다. 디스패리티는 실리콘 영역 에칭 공정 적용에 따른 화소 높이 차이를 가지는 두 센서의 계산된 결과들로 비교한다. 디스페리티를 계산하기 위해 설계된 센서의 특성 외에도 카메라 렌즈의 특성이 요구된다. 따라서, 두 가지의 카메라 렌즈 특성을 이용하여 디스패리티를 계산하고 비교하였다.

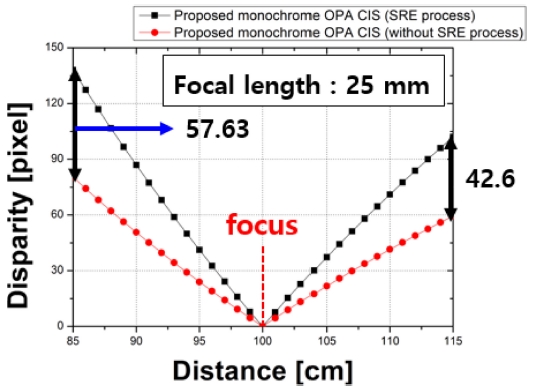

Fig. 7은 설계된 CMOS 이미지 센서와 Edmund 사의 C 시리즈 고정 초점 거리 렌즈 특성을 이용하여 계산된 디스패리티를 보여준다. 카메라 렌즈의 초점 거리는 25 mm이고, f-수 값은 1.4이다. 초점은 100 cm에 맞추고 물체 거리는 1 cm간격으로 85 cm부터 115 cm까지의 거리에 대하여 디스패리티를 계산하였다.

물체의 거리가 85 cm 인 경우, 실리콘 영역 에칭 공정이 적용되지 않은 센서의 디스패리티는 80.44 화소이다. 이 때, 실리콘 영역 에칭 공정이 적용된 센서의 디스패리티는 138.07 화소이다. 물체 거리가 115 cm인 경우, 실리콘 영역 에칭 공정이 적용되지 않은 센서의 디스패리티는 59.45 화소이다. 반면에, 실리콘 영역 에칭 공정이 적용된 센서의 디스패리티는 102.05 화소이다. 계산된 결과에서 보여지듯, 실리콘 영역 에칭 공정이 적용된 센서의 디스패리티가 물체 거리 85 cm에서 57.63화소, 물체 거리115 cm에서 42.6 화소로 향상되었다.

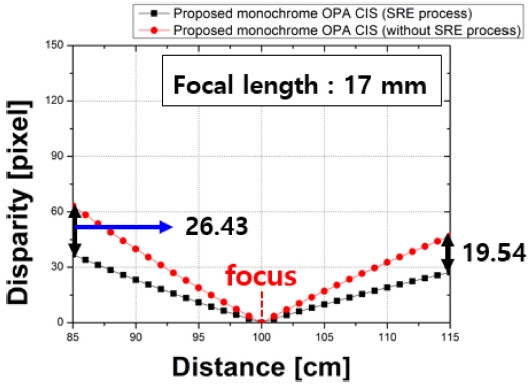

Fig. 8은 설계된 센서와 THORLABS의 MVL17HS-17 mm EFL 렌즈의 특성을 이용하여 계산한 결과를 나타낸다. 거리에 대한 계산 조건은 Fig. 7과 동일하다. 카메라 렌즈의 초점 거리는 17 mm이며, f-수는 0.95이다. 물체의 거리가 85 cm 인 경우, 실리콘 영역 에칭 공정이 적용되지 않은 센서의 디스패리티는 36.89 화소이다. 이때, 실리콘 영역 에칭 공정이 적용된 센서의 디스패리티는 63.32 화소이다. 물체 거리가 115 cm인 경우, 실리콘 영역 에칭 공정이 적용되지 않은 센서의 디스패리티는 27.26 화소이다. 반면에, 실리콘 영역 에칭 공정이 적용된 센서의 디스패리티는 46.80 화소이다. 두 결과에서 확인할 수 있는 것처럼, 실리콘 영역 에칭 공정이 적용된 센서의 디스패리티가 향상된다.

Calculated disparity results using the characteristics of the designed sensor and 17mm focal length camera lens.

두 결과에서 공통적으로 나타나는 현상은 초점 거리를 기준으로 좌우 디스패리티의 비대칭 현상이다. 이는 디스패리티의 경향이 비선형이기 때문에 발생한다. 왜냐하면, 왼쪽-오프셋 화소 조리개와 오른쪽-오프셋 화소 조리개 두 이미지의 디스패리티가 거리가 멀어질 수로 변화폭이 줄어 들기 때문이다.

5. 결 론

오프셋 화소 조리개 방법이 적용되어 설계된 단색 CMOS 이미지 센서에서 깊이 정보 추출을 위한 디스패리티를 추정하는 방법을 제시하였다. 이는 단색 센서뿐 만 아니라 오프셋 화소 조리개 방법이 적용된 모든 이미지 센서에 적용이 가능하다. 디스패리티는 깊이 정보를 추출하여 3차원 이미지를 구현하기 위한 가장 중요한 요소이다. 오프셋 화소 조리개 방법을 적용하여 화소를 설계할 때, 중요하게 고려할 특성은 픽셀의 높이와 오프셋 화소 조리개의 오프셋 값이다. 본 논문에서는 오프셋 값을 가능한 최대로 하였다.

실리콘 영역 에칭 공정 적용 유무에 따라 설계된 두 개의 단색 CMOS 이미지 센서에 대하여 계산된 디스패리티를 비교한 결과, 결론적으로, 실리콘 영역 에칭 공정이 적용된 센서가 FOA 값이 감소함에 따라 디스패리티가 개선되었음을 확인하였다.

Acknowledgments

본 논문은 Center for Integrated Smart Sensors funded by the Ministry of Science and ICT as the Global Frontier Project (CISS-2016M3A6A6931333)와 BK21 Plus project funded by the Ministry of Education, Korea (21A20131600011)의 지원에 의하여 연구되었다.

References

-

M. Mase, S. Kawahito, M. Sasaki, Y. Wakamori, and M. Furuta, “A wide dynamic range CMOS image sensor with multiple exposure-time signal outputs and 12-bit column-parallel cyclic A/D converters”, IEEE J. Solid-State Circuits, Vol. 40, No. 12, pp. 2787-2795, 2005.

[https://doi.org/10.1109/JSSC.2005.858477]

- R. Reshef, T. Leitner, S. Alfassi, E. Sarig, N. Golan, O. Berman, A. Fenigstein, H. Wolf, G. Hevel, S. Vilan, and A. Lahav, “Large-Format Medical X-Ray CMOS Image Sensor for High Resolution High Frame Rate Applications”, Int. Image Sens. Work., No. 972, pp. 2-5, 2009.

-

N. Akahane and S. Sugawa, “Wide Dynamic Range CMOS Image Sensors for High Quality Digital Camera, Security, Automotive and Medical Applications”, Proc. IEEE Sens., pp. 396-399, 2006.

[https://doi.org/10.1109/ICSENS.2007.355489]

- T. Yu, G. Fu, Y. Qiu, and Y. Wang, “Noise Power Spectrum Estimation of Column Fixed Pattern Noise in CMOS Image Sensors Based on AR Model”, 2019 Progn. Syst. Health Manag. Conf. PHAI-Qingdao 2019, No. 1707, pp. 1-5, 2019.

-

A. R. Ximenes, P. Padmanabhan, M. J. Lee, Y. Yamashita, D. N. Yaung, and E. Charbon, “A 256×256 45/65nm 3D-stacked SPAD-based direct TOF image sensor for LiDAR applications with optical polar modulation for up to 18.6dB interference suppression”, Dig. Tech. Pap. - IEEE Int. Solid-State Circuits Conf., Vol. 61, pp. 96-98, 2018.

[https://doi.org/10.1109/ISSCC.2018.8310201]

-

Y. Shirakawa, K. Yasutomi, K. Kagawa, S. Aoyama, and S. Kawahito, “An 8-tap CMOS lock-in pixel image sensor for short-pulse time-of-flight measurements”, Sensors, Vol. 20, No. 4, pp. 1040(1)-1040(16), 2020.

[https://doi.org/10.3390/s20041040]

-

S. Lee, K. Yasutomi, M. Morita, H. Kawanishi, and S. Kawahito, “A time-of-flight range sensor using four-tap lock-in pixels with high near infrared sensitivity for lidar applications”, Sensors, Vol. 20, No. 1, pp. 116(1)-116(17), 2020.

[https://doi.org/10.3390/s20010116]

-

M. El-Khamy, X. Du, H. Ren, and J. Lee, “Multi-Task Learning of Depth from Tele and Wide Stereo Image Pairs”, Proc. Int. Conf. Image Process. ICIP, Vol. 2019-September, pp. 4300-4304, 2019.

[https://doi.org/10.1109/ICIP.2019.8803566]

-

J. Lee, B.-S. Choi, S.-H. Kim, J. Lee, J. Lee, S. Chang, J.H. Park, S.-J. Lee, and J.-K. Shin, “Effects of Offset Pixel Aperture Width on the Performances of Monochrome CMOS Image Sensors for Depth Extraction”, Sensors, Vol. 19, No. 8, pp. 1823(1)-1823(11), 2019.

[https://doi.org/10.3390/s19081823]

- B.-S. Choi, M. Bae, S.-H. Kim, J. Lee, C. W. Oh, S. Chang, J. H. Park, S.-J. Lee, and J.-K. Shin, “CMOS image sensor for extracting depth information using offset pixel aperture technique”, 2018 IEEE Int. Instrum. Meas. Technol. Conf., pp. 3-5, 2017.

-

B.-S. Choi, J. Lee, S.-H. Kim, S. Chang, J. H. Park, S.-J. Lee, and J.-K. Shin, “Analysis of disparity information for depth extraction using CMOS image sensor with offset pixel aperture technique”, Sensors, Vol. 19, No. 3, pp. 472(1)-472(10), 2019.

[https://doi.org/10.3390/s19030472]