라플라시안 피라미드와 주성분 분석을 이용한 가시광과 적외선 영상 합성

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(https://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

Abstract

This study proposes a method of blending visible and near infrared images to enhance edge details and local contrast. The proposed method consists of radiance map generation and color compensation. The radiance map is produced by a Laplacian pyramid and a soft mixing method based on principal component analysis. The color compensation method uses the ratio between the composed radiance map and the luminance channel of a visible image to preserve the visible image chrominance. The proposed method has better edge details compared to a conventional visible and NIR image blending method.

Keywords:

Near infrared, Image blending, Image enhance, Laplacian pyramid, Principal component analysis, Soft mixing1. 서 론

일반적으로 카메라와 캠코더에 사용되는 이미지센서는 가시광 대역 뿐만 아니라 근적외선 대역의 이미지를 획득할 수 있다. CCTV 감시용 카메라의 경우 낮의 경우 적외선 차단 필터를 사용하여 가시광 영상만을 촬영하지만 밤의 경우 가시광이 부족한 환경에서 적외선 보조광을 이용하여 적외선 영상을 촬영한다. 또한 낮의 밝은 경우라도, 근적외선 대역은 가시광 대역 범위의 장면 이상의 상당한 정보를 포함하고 있기 때문에 영상 합성에 자주 사용되고 있다. 근적외선 스펙트럼은 700 nm에서 1100 nm의 파장에 걸쳐 있고, 가시광선보다 산란성이 적으며, 이는 적외선 이미지가 안개, 그늘진 곳에서 더 많은 정보를 얻을 수 있도록 해준다. 즉, 근적외선 영상을 촬영할 때의 장점은 일반적으로 가시적인 장면에서 촬영되지 않는 상세한 경계 정보를 얻는 것이다[1-4].

기존의 가시광 영상과 적외선 영상의 합성 방법은 주로 디헤이즈(dehaze)에 사용되고 있다. 가시광 대역 영상과 근적외선 영상을 합성하기 위해, 기존 방법들은 다중 해상도 분해 알고리즘과 다중 해상도 정보 기반의 융합 알고리즘을 사용한다. 다중 해상도 분해는 근적외선 영상에서 세부 정보를 찾는데 중요하다. 적외선 영상을 이용하면 어두운 영역에서 더 나은 디헤이즈 처리가 가능하고, 높은 대비 정보 및 경계 정보를 잘 보존할 수 있다.

대표적인 가시광 및 적외선 영상 합성 알고리즘은 라플라시안-가우시안(Laplacians-Gaussian) 피라미드(pyramid)와 지역 엔트로피(local entropy)를 사용한다[1]. 로컬 엔트로피는 합성 알고리즘에서 가시광 및 근적외선 영상 중 최대 정보를 전송하는 데에 사용된다. 또한 이 기법은 다해상도 라플라시안-가우시안 피라미드를 사용하였고 이를 통해 분해된 다중 분해 영상은 로컬 엔트로피 정보 기반 합성 방법을 이용하여 각 층에서 부드럽게 합성된다. 그러나 근적외선 영상의 세부적인 디테일을 잘 살리지 못하고 색 보상을 하면 경계 정보들이 제대로 드러나지 않는 현상이 발견된다.

본 논문에서는 라플라시안 피라미드를 이용한 다해상도 영상 분해와 주성분 분석을 이용한 영상 융합 기법을 제안했다. 특정 국부 영역에서 가중치 맵을 생성하는 방법과 합성이 불필요한 영역에서는 주성분 분석을 통해 영상 합성을 줄임으로써 합성에 따른 부작용을 줄였다. 주성분 분석을 통한 영상 합성으로 근적외선 영상에 있는 경계 정보들이 잘 보존됨을 확인하였다. 제안된 방법은 기존 방법과 비교하여 국부적인 대비와 세부적인 디테일 표현에서 더 개선되었다.

본 논문은 2장에서 관련 연구에 대하여 소개하고, 3장에서 제안한 영상 취득 방법, 방사맵 합성, 및 색 보상 방법을 설명하며, 4장에서 제안 방법에 대한 검증 및 성능 평가를 위한 실험결과를 제시한다.

2. 관련 연구

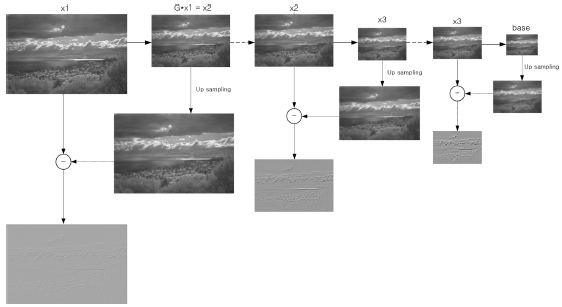

2.1 라플라시안 피라미드 영상 분해

라플라시안 피라미드는 입력 영상에서 다중 스케일 영상을 추출하는 다중 스케일 분해 처리 알고리즘 중 하나이다[5]. 라플라시안 피라미드 영상은 각각의 피라미드 레벨에 의해 별도로 처리될 수 있다. 라플라시안 피라미드의 다중 스케일 영상은 입력 영상에서 차 영상과 가우시안 블러, 업-다운 샘플링(up-down sampling)을 이용하여 얻을 수 있다. 라플라시안 피라미드의 첫 번째 단계는 가우시안 피라미드 분해다. 가우시안 피라미드는 가우시안 블러와 다운 샘플링으로 다중 영상 계층을 만든다. 식(1)은 가우시안 블러 함수를 이차원화한 필터를 나타낸다. 식에서 w(x,y)는 가우시안 블러 함수이고, σ값에 따라 크기가 달라진다. 일반적으로 5×5 필터 사이즈의 가우시안 블러 처리 후 영상을 다운 샘플링한다.

| (1) |

영상의 블러 처리는 각 픽셀 레벨을 주변 픽셀의 평균 값으로 계산하는 것으로 영상 처리 관점에서 고주파 성분을 제거하는 과정이다. 다운 샘플링 하기 전에 블러 처리를 하는 이유는 고주파 성분 중 에일리어싱(aliasing)을 일으키는 성분을 제거하기 위함이다. 다음 블러된 영상을 다운 샘플링하여 저해상도 영상을 생성한다. 가우시안 피라미드의 과정은 이러한 블러 단계와 다운 샘플링 단계를 반복하여 다중 해상도 영상 계층을 생성하는 것이다. 식(2)에서 식 (4)는 가우시안 블러와 다운 샘플링 과정을 나타낸다. 식(2)에서 w(m,n) 은 가우시안 블러 필터, gi 는 입력 영상, gi+1(i,j) 은 입력 영상 gi 에 대해 한단계 진행된 가우시안 피라미드 영상이다. 다음 가우시안 피라미드는 다른 크기의 영상에 대해 반복 수행된다.

| (2) |

라플라시안 피라미드를 생성하는 두 번째 단계는 가우시안 피라미드 영상을 업 샘플링하고 이전 단계 영상을 빼서 차 영상을 구하는 것이다. 식(3)에서는 식(2)에서 구한 가우시안 피라미드 영상 gi+1을 업 샘플링하고, 식(4)에서 이전 단계에 구한 가우시안 피라미드 영상 gi 와 업 샘플링한 Expand(gi+1(i,j)) 의 차영상을 구한다. 복원 영상 계산은 역의 과정으로 라플라시안 피라미드의 최하단 이미지를 업 샘플링하고 차 영상을 더하는 반복적인 과정을 통해 기존 원본 영상을 획득할 수 있다.

| (3) |

| (4) |

요약된 라플라시안 피라미드 진행 과정은 Fig. 1과 같다.

2.2 주성분 분석

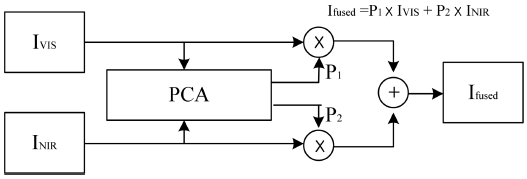

주성분 분석은 데이터 분포에 대한 최적 가중치를 선형 조합하는 방법이다[6]. 주성분 분석(Principal Component Analysis)에서 데이터의 공분산 행렬과 고유벡터를 사용하여 데이터 주성분을 계산한다. 공분산 행렬의 고유 벡터는 데이터의 분포 방향을 보여준다. 따라서, 고유벡터는 주요 요소에 대한 영향을 결정하는 데 이용된다. 고유벡터의 방향이 바뀌지 않고 크기만 바꿀 수 있기 때문에 주요 요소들에 대한 기준 축으로 볼 수 있다.

주성분 분석은 공분산 행렬과 고유벡터로 구성된 기준 축을 찾는 방법이다. 주성분 분석의 축 개수는 데이터의 차수에 따라 달라진다. 영상 융합에서는 두 개의 축만 고려한다. 첫번째 축은 영상의 데이터 분포에서 최대 분산에 해당하는 축으로 데이터의 분포가 가장 길게 분포하는 방향이다. 두번째 축은 첫 번째 주성분 축에 수직에 해당되는 축이다. 주성분 분석은 입력 데이터의 공분산에 의해 계산된 고유 값 분해와 관련 있다.

주성분 분석 알고리즘의 첫번째 단계는 입력 영상의 열 벡터를 생성하는 것이다. 식(5)는 입력 영상의 평균 값을 구하는 식이고 식(6)은 식(5)에서 구한 평균으로 공분산 행렬을 구하는 식이다. 식(7)에서 고유벡터와 고유 값을 구하며, 여기서 행렬 A는 공분산 행렬이고, λ은 행렬식에 의해 산출된 고유 값이다. 고유 벡터 x는 고유 값 λ를 Ax = λx 에 대입하여 구할 수 있다. 다음으로 식(8)에서 두 개의 고유 값 중 더 큰 고유 값에 해당하는 고유벡터 열을 정규화 한 P1 과 P2 의 값을 구다. 식에서 Ev 열 고유벡터, Ev1 과 Ev2 는 열 고유벡터 Ev1 를 구성하는 각각의 요소의 값, P1 과 P2 주성분 분석 가중치이고 두 가중치의 합은 1이다.

| (5) |

| (6) |

| (7) |

| (8) |

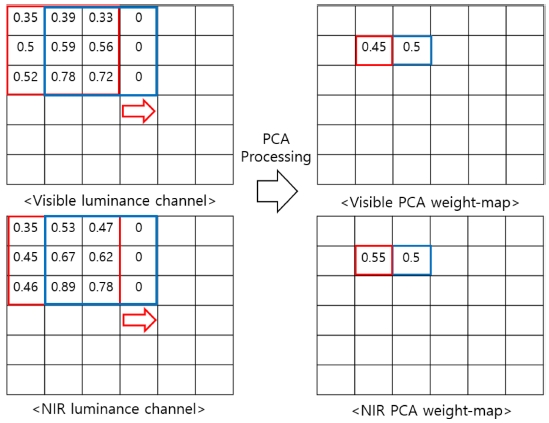

주성분 분석 합성은 고유 열 벡터의 평균 가중치 P1 과 P2 에 의해 수행되며, 각 입력 영상에서 가중치를 곱하여 산출된다[6,7]. 식(9)는 입력 영상과 주성분 분석 가중치를 각각 곱하여 더한 합성 영상에 대한 수식이다. Ifused 는 주성분 분석 합성 결과, IVIS 와 INIR 는 가시광과 근적외선의 입력 영상이다. 제안된 방법은 주성분 분석 알고리즘에서 얻은 가중치로 Fig. 2에 보인 바와 같이 가시광선 입력 영상과 근적외선 입력 영상을 합성하는 데 사용된다.

| (9) |

3. 제안 방법

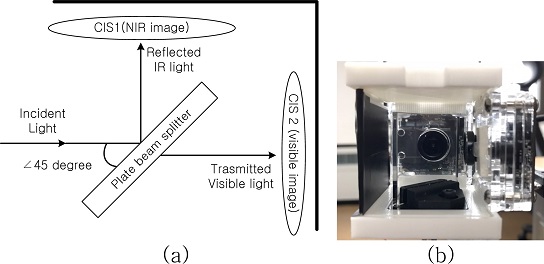

3.1 가시광 및 근적외선 영상 취득

먼저, 가시광 및 근적외선 대역 영상의 취득을 위해 빔 스플리터(beam splitter)와2개의 이미지 센서를 이용하여 다중 대역 영상 촬영기를 설계하였다. Fig. 3은 카메라 모듈 구성과 제작된 촬영기를 보여준다. 먼저 입사된 광은 빔 스플리터에 의해 45도 각도로 대역 분리가 발생된다. 빔 스플리터 사용 스펙은 35×35 mm, 30R/70T, 45o Hot mirror VIS plate beam splitter이고, 가시광 대역은 통과시키고 근적외선 대역은 반사시키는 역할을 한다. Table 1은 빔 스플리터의 빛 투과 및 반사율과 파장 대역을 나타낸다. 다음 빔 스플리터의 수직방향으로 근적외선 영상촬영을 위한 카메라가 배치되고 빔 스플리터를 통과하는 방향으로 가시광 영상 촬영을 위한 카메라가 배치된다.

카메라 모듈은 동일한 두 대의 카메라와 빔 스플리터로 구성되어, 동일한 광 경로에서 가시광 영상과 근적외선 영상을 촬영할 수 있다. 이때 카메라의 적외선 차단 필터는 제거 되었다.

제안한 카메라 모듈로 사진을 찍었을 때, 빔 스플리터의 광경로 오차 특성과 기구물의 부족한 정밀성으로 인하여 가사광선 영상과 근적외선 영상의 정렬이 일치하지 않는다. 따라서, 후보정을 위해 호모그래피(homography) 기법을 사용하였다[12]. 호모그래피 처리에서 한 평면이 다른 평면에 투영할 때 대응되는 투영점이 발생하며, 이러한 대응되는 점들은 일정한 변환 관계를 갖게 되고 동일 장면에 대해 다른 크기와 각도로 찍힌 영상들을 정렬하는 방법으로 사용된다. 호모그래피의 핵심은 3x3 호모그래피 행렬을 계산하는 것이고, 행렬 H 는 그라운드 좌표 및 영상 좌표에 의해 계산된다. 일반적으로 호모그래피 이론에서는 4개의 대응점만 있으면 된다.

식(10)에서 식(16)은 호모그래피 행렬 계산식을 나타낸다. 여기서 X′ 는 기준 영상, X 는 대상 영상, H 는 호모그래피 행렬이다. 식(11)은 식(10)을 행렬화 하여 나타낸 수식이고, 식(11)에서 xi 와 yi 는 기준 영상 좌표, xg 와 yg 는 대상 영상 좌표이다. h1 ~ hg 3x3 행렬은 호모그래피 결과 행렬이다. 이 행렬로부터 가시광 영상과 근적외선 영상을 정렬할 수 있다. 식(12)와 식(13)은 식(11)에서 구한 행렬 방정식이고, 첫번째 행의 방정식을 세번째 행의 방정식으로 나누면 식(12)와 같은 행렬 방정식이 된다. 또한, 두번째 행의 방정식을 위의 방법과 같이 세번째 행의 방정식으로 나누면 식(13)과 같은 행렬 방정식이 된다.

식(10)에서 식(13)까지 계산한 행렬 방정식은 첫번째 대응점에 대한 계산 방법과 과정이고, 호모그래피에서 최소 4개의 대응점에 대한 계산을 하게 되므로, 위와 같은 방법으로 총 4번 계산해야 한다. 따라서, 식(14), 식(15)는 식(12), 식(13)을 행렬로 표현한 식이다. 한 대응점 당 2개의 행렬 방정식이 생성되므로 식(14)의 행렬의 크기는 8×9 행렬이 된다. xg1 와 yg1 는 첫 번째 대응점에 해당하는 대상 영상 좌표이고, xg8 와 yg8 는 네번째 대응점에 해당하는 대상 영상좌표이다.

행렬 방정식은 Aj 와 h 로 나타낼 수 있는데 h 는 호모그래피 좌표를 일 차원 행렬로 나타내었다. 식(11)과 식(15)에서 h9 는 항상 1이다. 행렬 Aj 는 기준 영상과 대상 영상 사이에 대응되는 1~4번째 특징점을 나타내고 호모그래피 행렬 H 는 행렬 Aj 의 SVD(single value decomposition)를 적용시켜 산출할 수 있다.

| (10) |

| (11) |

| (12) |

| (13) |

| (14) |

| (15) |

| (16) |

3.2 주성분 분석 기반 방사맵 합성

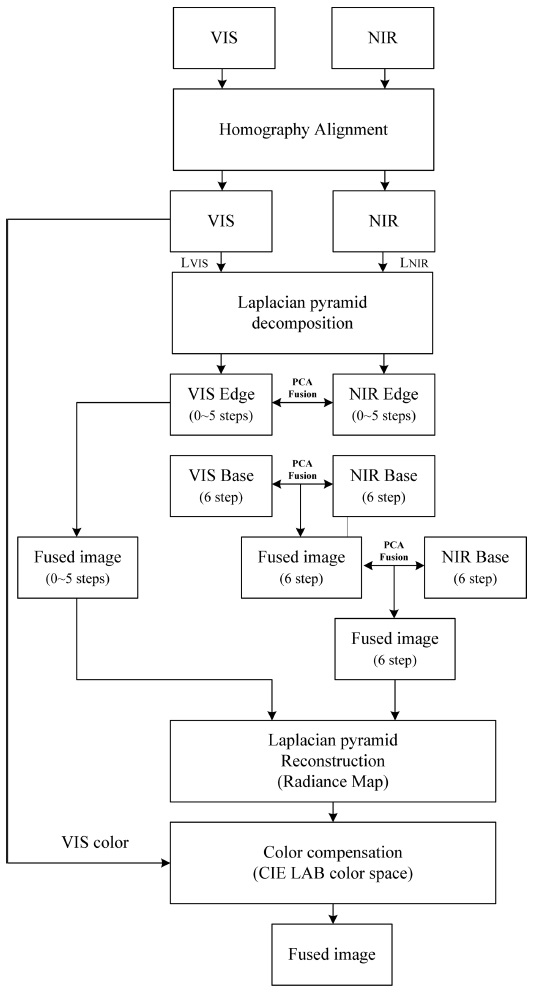

다음으로 촬영 장면에 대해 정렬된 가시광 및 근적외선 영상은 1개의 방사맵(혹은 휘도맵)으로 합성된다. 제안된 알고리즘의 흐름도는 Fig. 4에 나타내였다. 여기서 LVIS 는 가시광 영상의 휘도 채널이고 LNIR 은 근적외선 영상의 휘도 채널이다. 합성 알고리즘은 CIELAB 색공간의 휘도 채널에서 라플라시안 피라미드 분해와 주성분 분석 합성 알고리즘을 사용한다. 입력 영상은 라플라시안 피라미드 방법으로부터 디테일 레이어(detail layer)와 베이스 레이어(base layer)로 분해된다.

각 레이어는 주성분 분석 결과에 따라 소프트 믹싱(soft mixing) 방법을 사용하여 합성된다[8]. 제안된 주성분 분석 합성 알고리즘은 PCA 스키핑 마스트(skipping mask) 필터에 의해 불필요한 영역의 픽셀 값을 주성분 분석 계산하지 않고 다음 픽셀 영역으로 넘어가는 방법을 사용한다. 판별 기준은 PCA 스키핑 마스크 필터 영역에 있는 평균 픽셀 값에 따른다. 영역 내 평균 픽셀 값이 입력 영상 히스토그램 분포에서 픽셀 값이 전체 픽셀 값의 하위 10%에 해당하는 경우에는 주성분 분석 알고리즘을 처리하지 않는다. 주성분 분석 알고리즘에 의해 계산되지 않은 픽셀 값은 Fig. 5의 도식에 나타낸 것처럼 0.5 가중치로 디폴트 설정된다. 전체 픽셀 값의 히스토그램 분포에서 하위 10%를 생략하는 이유는 세부 레이어 영상에서 경계 성분을 제외한 대부분 픽셀 값이 0에 가깝기 때문이다. 이때 주성분 분석 필터마스크 크기는 라플라시안 피라미드 함수의 블러 변수(σ값) 크기에 따라 달라진다.

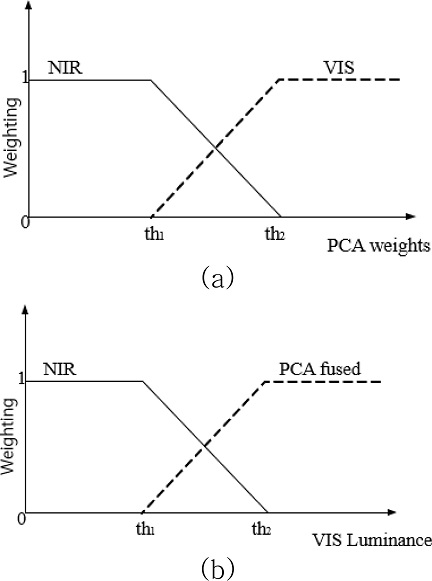

소프트 믹싱 방법은 Fig. 6에서 처럼 전환 영역 밖에서는 픽셀 값을 스위칭 선택하다가 전환 영역 안에서는 두 개의 픽셀 값을 합성한다. th1 과 th2 사이의 전환 영역 범위에서 두 개의 입력 영상을 선형적으로 혼합한다.

Soft mixing functions: (a) detail layer fusion using PCA level and (b) base layer fusion using visible luminance level.

전이 영역 합성 방정식은 식(17)에 나타내었다. 식에서 P 는 Fig. 5 에서 주성분 분석 방법으로 산출 된 주성분 분석 가중치값, P1 와 P2 는 각각 전이 영역에서의 가시광 및 근적외선 영상의 합성 가중치, th1 과 th2 는 0에서 1까지 범위의 상대적인 영역 문턱 값이다. 본 논문에서는 각 축의 값 분포 범위에서 20%와 80%의 레벨을 사용하였다. 디테일 레이어에서의 주성분 분석 합성 알고리즘은 다음 식(18)~(21)에 나타내었다.

| (17) |

| (18) |

| (19) |

| (20) |

| (21) |

여기서 Pdetail _1 과 Pdetail _2 는 식 (17)의 소프트 믹싱 방법을 적용한 디테일 가중치 맵이고, VISdetail 과 NIRdetail 은 가시광과 근적외선 영상을 라플라시안 피라미드로 산출한 디테일 레이어이다. Pbase _1 과 Pbase _2 는 베이스 가중치 맵이고, VISbase 와 NIRbase 는 가시광과 근적외선 영상에 대한 베이스 레이어이다. PVIS _L _1 과 PVIS _L _2 은 Fig.6 (b)에서 가시광 상대 휘도에 대한 가중치 맵이고, PCA _fused 는 식(19)에서 구한 베이스 레이어 융합 영상이다.

Fig.6 (a)에서 가시광 및 근적외선 디테일 레이어 합성은 기본적으로 PCA 가중치에 따라 합성된다. 그러나 Fig.6 (b)처럼 베이스 레이어의 합성은 베이스 레이어의 대비 성분이 작기 때문에 합성이 디테일 레이어와 다르게 수행된다. 베이스 레이어는 두 단계의 주성분 분석을 통해 합성된다. 첫번째 단계에서 기존 주성분 분석 합성 방법과 같이 식(19)의 PCA 가중치 기반으로 합성한다. 두번째 단계에서 주성분 분석 융합 베이스(PCA _fused)와 근적외선 베이스 레이어를 사용하여 2차 융합한다. 융합 베이스 레이어 정보를 사용하는 이유는 세부 성분이 거의 없는 베이스 성분 융합의 경우 가시광 영상을 그대로 사용하게 되면 어두운 영역의 베이스 성분 유입이 커져 그늘이나 역광에 의해 영상 전체의 톤 압축 효과가 줄어 들게 된다.

마지막으로 합성 방사맵(radiance map)을 생성하기 위해 식(21)의 복원 라플라시안 피라미드 알고리즘을 적용한다. 식에서 radn 는 n번째 레이어의 합성 영상 결과를, Expand(radn+1) 는 라플라시안 피라미드 복원 과정(식(3))을 거친 주성분 분석 합성 결과 영상이다. 라플라시안 피라미드의 복원은 하부 레이어에 업 샘플링을 수행하고 이전 레이어와 결합하는 과정을 거친다. 주성분 분석으로 합성된 베이스 및 디테일 레이어들은 라플라시안 피라미드 복원에 의해 결합되며 제안하는 합성 방사맵이 된다.

3.3 색 보정

가시광과 근적외선 영상의 융합된 방사맵의 휘도 성분과 가시광 입력의 색 성분 조합을 위해서 휘도 변화가 반영된 색 성분 보정이 필요하다[13]. 융합된 휘도 방사맵과 가시광 영상은 큰 밝기 차이를 가지기 때문에 색 보상은 톤 스케일 변화를 고려해야 한다. 따라서 색 성분의 보상비는 방사맵과 가시광 영상의 휘도 채널 비율로 쉽게 구해진다. CIELAB 색 공간에서 색 보정 식은 다음과 같다.

| (22) |

| (23) |

| (24) |

여기서 a 와 b 는 CIELAB 색 공간의 색 성분 채널이고, a′ 과 b′ 은 식(22)의 비율을 적용한 보정된 색 성분 채널이다.

4. 결과 및 고찰

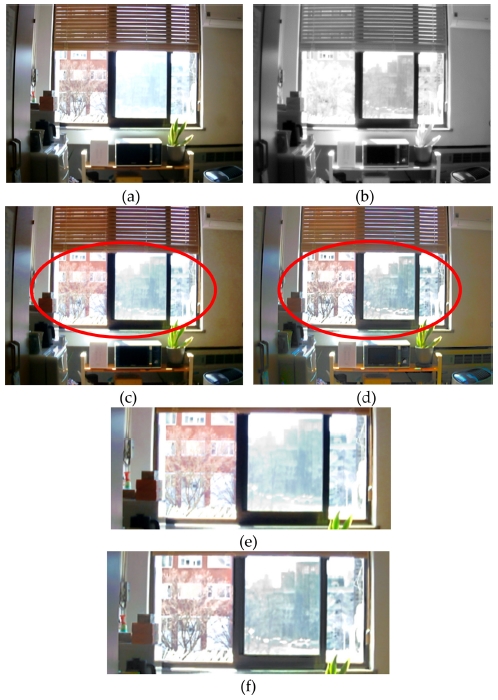

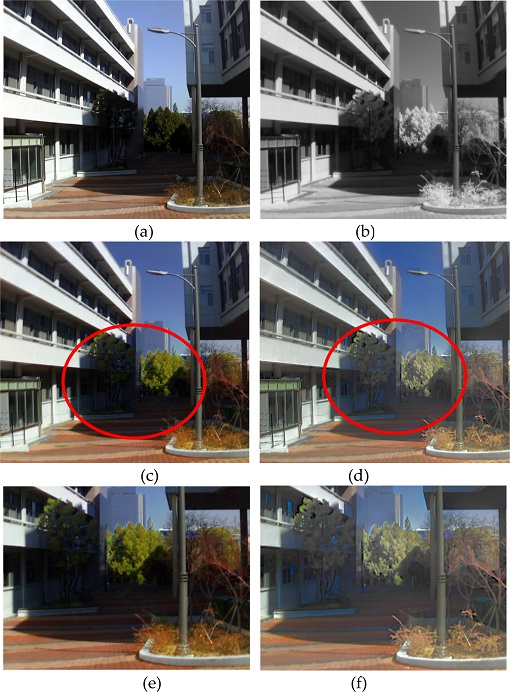

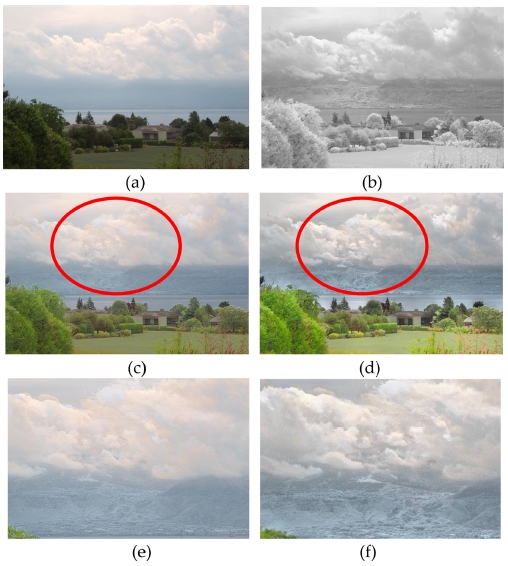

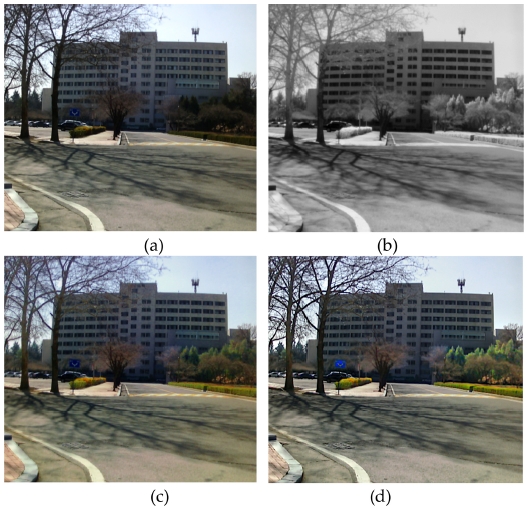

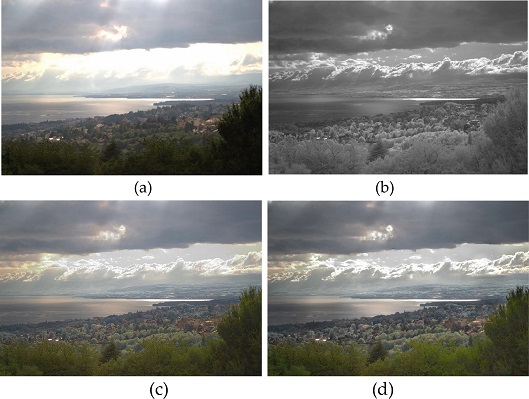

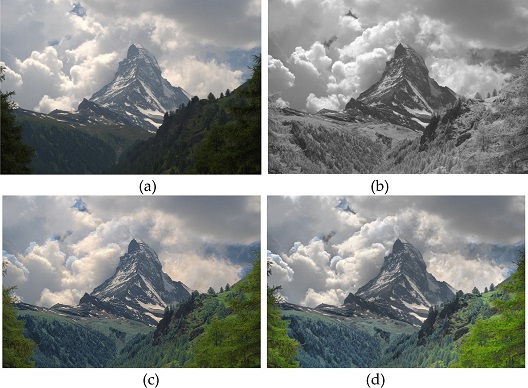

제안 방법과 기존의 방법[1]과의 비교를 위해 제작한 카메라 모듈로 촬영한 영상(Figs. 7,8,10)을 포함하여 8가지 영상에 대해 정성, 정량적인 결과 화질 평가를 하였다. 가시광 및 근적외선 영상은 주간 조건에서 촬영하였다. Fig. 7결과 영상에서, 제안된 방법은 기존 방법에 비해 창문 밖에 비춰진 건축물에 대한 디테일을 더 잘 표현하고 있다. 가시광에 비해 투과성이 좋은 근적외선 입력 영상에 대한 정보가 잘 반영되었다. 또한, 아래 실내 영상 부분도 제안된 방법에서 색 표현 및 명도 대비가 우수하다. Fig. 8결과 영상에서, 제안된 방법은 건물 그림자에 의해 가시광 영상에서는 잘 보이지 않는 나무를 기존 방법과 비교하여 더욱 잘 나타내고 있다. 또한 Fig. 9에서 제안된 방법은 적외선 영상의 구름 디테일을 선명하게 표현하고 역광 상황의 나무의 섬세함도 잘 표현하고 있다. 반면 기존 방법은 가시광 영상의 밝은 영역의 가중치가 높아서 적외선 영상의 장점을 잘 반영하고 있지 않고 영상 전반의 대비가 살아나지 않는다.

Input image pair and resulting images(1): (a) input visible image, (b) input NIR image, (c) conventional method, (d) proposed method, (e) cropped image of (c) and (f) cropped image of (d).

Input image pair and resulting images(2): (a) input visible image, (b) input NIR image, (c) conventional method, (d) proposed method, (e) cropped image of (c) and (f) cropped image of (d).

Input image pair and resulting images(3): (a) input visible image, (b) input NIR image, (c) conventional method, (d) proposed method, (e) cropped image of (c) and (f) cropped image of (d).

Input image pair and resulting images(4): (a) input visible image, (b) input NIR image, (c) conventional method, and (d) proposed method

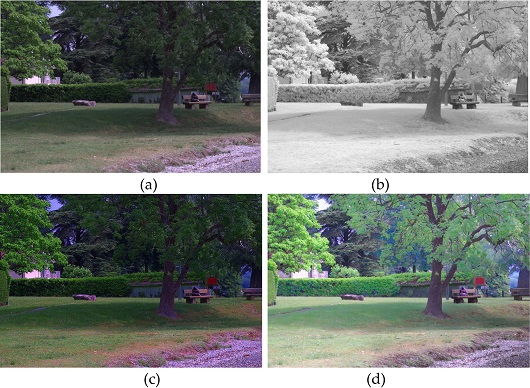

특히 Fig. 10, Fig. 13, 및 Fig. 14에서 어두운 영역의 밝기, 디테일, 채도 등이 제안 방법에서 선명하게 표현됨을 확인할 수 있다. Fig. 11과 Fig. 12 처럼 실험 영상들 중 구름, 창문, 역광 등 상황에서 투과성과 회절성이 좋은 근적외선 영상의 디테일이 제안한 방법의 결과에서 더 잘 표현할 수 있다는 것을 쉽게 확인 할 수 있다.

Input image pair and resulting images(5): (a) input visible image, (b) input NIR image, (c) conventional method, and (d) proposed method

Input image pair and resulting images(6): (a) input visible image, (b) input NIR image, (c) conventional method, and (d) proposed method

Input image pair and resulting images(7): (a) input visible image, (b) input NIR image, (c) conventional method, and (d) proposed method

Input image pair and resulting images(8): (a) input visible image, (b) input NIR image, (c) conventional method, and (d) proposed method

결과 영상의 객관적인 화질 평가를 위해 영상의 선명도 지표를 측정하여 Table 2에 나타내었다. Jpeg_quality[9]는 별도의 비교 이미지 없이 대비 값에 따른 각 jpeg 이미지의 품질을 평가하는 방법이다. Fmi[10]는 두 개의 입력 영상 상호간의 정보 계산에 기초한 합성 영상 화질의 평가를 산출하는 방법이고 S3[11]은 영상에서 국부적으로 인식된 선명도에 따라 측정되는 객관 지표이다. 결과 값에서 지안 방법을 기존 방법과 비교하였을 때, 제안된 방법의 영상 평가 지표 평균 점수가 전체적으로 우수함이 확인된다. 특히 합성 영상 화질 평가인 Fmi 방법에서 기존 방식과 비교하여 큰 향상도를 보여준다.

5. 결 론

본 논문은 효과적인 가시광 및 근적외선 영상 합성 방법을 제안한다. 제안된 방사맵(radiance map)은 주성분 분석에 기초한 라플라시안 피라미드와 소프트 믹싱 방법을 사용하여 생성된다. 각 피라미드 레벨에서 처리는 CIELAB 색상 공간의 휘도 채널에서 수행되었다. 라플라시안 피라미드 분해를 통해 두가지 대역 영상은 디테일 레이어와 베이스 레이어로 분해되고, 분해된 레이어는 주성분 분석 기반으로 계층 별로 다른 소프트 믹싱 방법을 적용하여 합성 하였다. 특히 베이스 레이어 합성은 베이스 레이어의 전역 휘도 성분 압축을 높이고 국부 선명도를 높이기 위해 근적외선 베이스 레이어에 대한 가중치를 가시광 휘도 레벨에 반비례하도록 함으로써 국부 대비 효과를 개선하였다. 결과 영상 실험과 비교 평가에서 제안된 방법의 결과 영상은 정량, 정성적으로 우수한 명도 대비, 음영 지역 디테일, 그리고 색 표현을 나타내었다. 향후 연구에서 야간 상황에서 보조광을 이용한 가시광과 근적외선 영상 촬영과 융합을 연구할 필요가 있다.

Acknowledgments

이 논문은 2019년도 정부(교육부)의 재원으로 한국연구재단의 지원을 받아 수행된 기초연구사업임. (NRF-2019R1D1A3A03020225)

References

-

A. V. Vanmali, and V. M. Gadre, “Visible and NIR image fusion using weight-map-guided Laplacian–Gaussian pyramid for improving scene visibility”, Sadhana, Vol.42, No.7, pp.1063-1082, 2017.

[https://doi.org/10.1007/s12046-017-0673-1]

-

T. Kil, and N. I. Cho, “Image Fusion using RGB and Near Infrared Image”, J. Broadcast. Eng., Vol.21, No.4, pp.515-524, 2016.

[https://doi.org/10.5909/JBE.2016.21.4.515]

-

Z. Sadeghipoor, Y. M. Lu, and S. Süsstrunk, “Correlation-based joint acquisition and demosaicing of visible and near-infrared images”, Proc. Int. Conf. on Image Processing, ICIP, pp.3165-3168, Brussels, Belguim, 2011.

[https://doi.org/10.1109/ICIP.2011.6116339]

- X. Zhang, T. Sim, and X. Miao, “Enhancing photographs with near infrared images”, 26th IEEE Conf. on Comput. Vis. Pattern Recognit., pp.24-26, Anchorage, USA, 2008.

-

P. J. Burt, and E. H. Adelson, “The Laplacian Pyramid as a Compact Image Code BT”, Fundam. Pap. Wavelet Theory, Vol.C, No.4, pp.532-540, 1983.

[https://doi.org/10.1109/TCOM.1983.1095851]

-

R. P. Desale, and S. V. Verma, “Study and analysis of PCA, DCT & DWT based image fusion techniques”, Int. Conf. on Signal Process., Image Process. Pattern Recognit., pp.66-69, Coimbatore, India, 2013.

[https://doi.org/10.1109/ICSIPR.2013.6497960]

-

R. Kaur and S. Kaur, “An Approach for Image Fusion using PCA and Genetic Algorithm”, Int. J. Comput. Appl., Vol.145, No.6, pp.54-59, 2016.

[https://doi.org/10.5120/ijca2016910816]

-

H. J. Kwon, S. H. Lee, G. Y. Lee, and K. I. Sohng, “Radiance map construction based on spatial and intensity correlations between le and SE images for HDR imaging”, J. Vis. Commun. Image Represent., Vol. 38, pp.695-703, 2016.

[https://doi.org/10.1016/j.jvcir.2016.04.022]

- Z. Wang, H. R. Sheikh, and A. C. Bovik, “No reference perceptual quality assessment of JPEG compressed images”, IEEE Int. Conf. Image Process., Vol.1, pp.477-480, 2002.

-

M. B. A. Haghighat, A. Aghagolzadeh, and H. Seyedarabi, “A non-reference image fusion metric based on mutual information of image features”, Comput. Electr. Eng., Vol.37, No.5, pp.744-756, 2011.

[https://doi.org/10.1016/j.compeleceng.2011.07.012]

-

C. T. Vu, T. D. Phan, and D. M. Chandler, “S 3: A spectral and spatial measure of local perceived sharpness in natural images”, IEEE Trans. Image Process., Vol.21, No.3, pp.934-945, 2012.

[https://doi.org/10.1109/TIP.2011.2169974]

- R. Sukthankar, R. G. Stockton, and M. D. Mullin, “Smarter presentations: Exploiting homography in camera-projector systems”, Proc. IEEE Int. Conf. Comput. Vis., Vol.1, pp. 247-253, 2001.

-

H. J. Kwon and S. H. Lee, “CAM-based HDR image reproduction using CA-TC decoupled JCh decomposition”, Signal Process.: Image Commun., Vol.70, pp.1-13, 2019.

[https://doi.org/10.1016/j.image.2018.08.010]